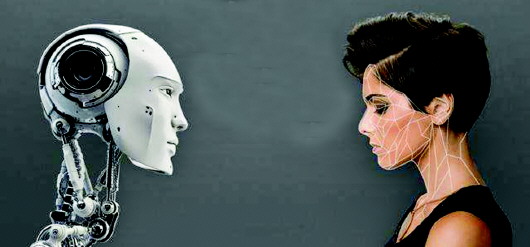

在学习了海量求职者数据之后,亚马逊的人工智能招聘软件患上了行业里潜在的性别歧视症。本该公平公正、没有意识的AI,竟然自己学会了“重男轻女”。最终,亚马逊还是放弃了这个秘密AI招聘工具。当然,这也不是AI第一次出现歧视行为。

本报记者 任志方

AI招聘算法优先选择男性求职者

当地时间10月10日,据路透社报道,亚马逊的机器学习专家表示,亚马逊设计的AI招聘算法中暗含了对女性求职者的偏见。

路透社援引了五位知情人士的消息称,从2014年起,亚马逊就在开发可以筛选求职者的程序,他们的目的很简单:像挑选商品一样,完成高效率、自动化的人才筛选。在形式上,亚马逊开发的AI招聘程序也与商城里的商品评分一样,从一星到五星,给每一个应聘者划分了等级,随后再交由人工人力资源按评价排名进行最后的筛选。

监管文件显示,当时亚马逊的人力资源部正在疯狂招揽新员工,2015年6月以来,亚马逊全球员工数量达到了近58万人,增加了两倍多。

正如所有基于人工智能的算法都需要不断通过机器学习新的数据来提高准确度,亚马逊的招聘算法亦然。问题是它基于十年来投递给公司的简历来训练算法模型,而这些简历大部分都是男性投递的,这是科技行业一个引人争议的现状,但算法并不知道如何应对这一情况,因此它就被训练成了对女性求职者有偏见,会优先选择男性求职者的算法。

据知情人士表示,在读取到带有“women's(女性、女子)”的相关词时,算法会降低简历的权重。比如简历中出现“女子象棋俱乐部队长”或者“女子学院”这样的关键词时,算法会直接对她们作降级处理。算法对简历上求职者提交的自我描述文案也有所偏好,比如算法会更多向“执行”“攻占”等在男性求职者简历中的高频词汇倾斜。

虽然亚马逊自己声称一直在权衡公司的员工多样性和平等,也为了防止程序产生偏见,特意编写过相关的代码,但机器学习一旦运转起来,黑箱给出的结果也很难追根溯源。此外,实践证明算法给出的“最佳人选”往往在工作中表现得并不尽如人意,“这个技术给出的结果几乎是随机的。”知情人士说道。

亚马逊高管没过多久就对这个项目失去了信心,开发团队也在去年初解散。

人工智能并非首次因歧视惹祸

事实上这也不是AI第一次因为数据的问题产生歧视行为。2015年,谷歌曾错误地将黑人程序员上传的自拍照打上“大猩猩”的标签,雅虎旗下的Flickr也曾错将黑人的照片标记成“猿猴”。

2016年,微软公司的AI聊天机器人Tay上线。Tay最初以一个清新可爱的少女形象出现,但是由于她的算法设定是通过学习网友的对话来丰富自己的语料库,很快她被网友充斥着激烈偏见的话语“带坏”,变成了一个彻底的仇视少数族裔、仇视女性、没有任何同情心的种族主义者。她成了这个社会一切偏见的集合体。

2017年3月,一名22岁的亚裔DJ在申请新西兰护照时遭拒,原因是他眼睛较小,处理照片的系统自行认定他“双眼闭上”,不符合相片要求。

算法歧视问题也不是近两年才出现的。以虚拟助手为例,处理比较简单的任务时,人工智能系统会偏向使用女声(例如Apple的Siri和亚马逊的Alexa);而解决疑难问题时,系统则选用男声(例如IBM的Watson和微软的Einstein)。由于在人工智能行业女性从业人数偏少,这更是增加了性别歧视的可能性。

2013年对谷歌搜索引擎的一项研究表明,非洲裔美国人更常用的名字可能与犯罪记录搜索结果密切相关。在过去很长一段时间里,在信用卡和金融服务领域,就存在贷款歧视现象。在社会群体中也会根据个人的身份、种族和地位,进行区分对待。人们越来越担心,大数据技术可能被用于算法歧视,波及的群体包括消费者、求职者、贷款者以及租赁用户。

与我们大多数人的认知相反,科技并不是客观的。AI算法和它们的决策程序是由它们的研发者塑造的,他们写入的代码,使用的“训练”数据还有他们对算法进行应力测试的过程,都会影响这些算法今后的选择。这意味着研发者的价值观、偏见和人类缺陷都会反映在软件上。

社会偏见潜藏于科技的客观性背后

算法偏见的情况还不止这些。从Facebook的新闻算法到医疗系统再到警用携带相机,我们作为社会的一部分极有可能对这些算法输入各式各样的偏见、性别歧视、仇外思想、社会经济地位歧视、确认偏误等等。这些被输入了偏见的机器会大量生产分配,将种种社会偏见潜藏于科技客观性的面纱之下。

此前,上海交大的研究人员测试了一种通过脸部识别来辨认罪犯的技术。他们用了1865张中国大陆人士及罪犯的护照照片给演算法测试,其中约730张是罪犯的照片,介于18岁至55岁,透过这些照片的共同点去辨认罪犯。两名研究员在论文中表示,此演算法在辨认罪犯上有89.5%的成功率。

据论文的检测标准显示,罪犯和常人的面部特征有三个,一是罪犯上唇的弯曲度比常人大23%;二是罪犯两只眼睛内角之间的距离比常人短6%;三是罪犯鼻尖到嘴角两条线的角度比常人小20%。

然而,这项披着AI外衣,貌似严谨的实验,得出的结论就一定靠谱吗?

英国爱丁堡大学犯罪学教授麦可维表示,如果凭借一个人的容貌来断定是否为罪犯,会让社会更加注重人的外表,换句话说,当陪审团判定一个人有没有犯罪,凭嫌疑犯的模样和穿着就可以定罪。

麦可维说,犯罪行为大多与社会环境因素有关,而不是遗传因素。若按照人工智能辨认罪犯的方法,社会会变得让某些人难以生存。因为罪犯将是先天,而不是根据事实和证据来判断。

第三方监管机构亟待建立

人工智能之所以作出有偏见的决定,根源有两方面,一方面,算法从获得的数据中分析并寻找模式,得出的结论是研究者无法预测的,另一方面,输入算法中的数据可能存在偏见,因此导致算法得出有偏见的结论。

不可否认,在一些社会领域,人工智能在作出公正、公平的决定上有着巨大潜力,例如医疗卫生方面,人工智能可以在临床试验上检测到人类无法察觉的临床表征,但同时,在劳工市场、司法系统等方面,却可能带来影响绝大多数人的严重后果,因此在运用时应该更加谨慎。

从一个信息高度匮乏的社会走到今天,不过是几十年的时间。但全球互联网所产生的数据量就已远远超过此前几千年人类社会积累的数据总和。当互联网的各种服务把信息推送到我们嘴边的时候,我们没有办法知道这一勺勺的数据中间有多少有益的营养成分,有多少可能的副作用,我们只能选择咽下去。

面对可能出现的算法歧视,一个值得信赖的第三方监管机构也亟待建立,对人们认为受到歧视的人工智能决定进行调查,对有关算法进行审计,这既能消除企业对商业机密外泄的担忧,同时也能让当事人对结果感到满意。

本稿件所含文字、图片和音视频资料,版权均属

齐鲁晚报所有,任何媒体、网站或个人未经授权不得转载,违者将依法追究责任。